V dnešní době roste poptávka po lokálním provozu jazykových modelů, a to zejména z důvodu ochrany soukromí, kontroly nad modelem a zajištění rychlého přístupu bez závislosti na externích serverech. Jedním z výkonných modelů dostupných pro lokální běh je DeepSeek R1, který lze provozovat přes oficiální aplikaci nebo přímo na vlastním zařízení. Pokud však nemáte dostatečně výkonné PC, můžete využít Google Colab, kde lze tento model spustit zdarma. Tento návod vás provede celým procesem.

Proč provozovat DeepSeek R1 lokálně?

DeepSeek R1 je výkonný jazykový model, který lze provozovat přes oficiální aplikaci nebo lokálně na vlastním zařízení. Lokální provoz má několik výhod:

- Ochrana soukromí – DeepSeek může odesílat uživatelská data do Číny, což může být bezpečnostní riziko.

- Plná kontrola nad modelem – lokální běh umožňuje experimentovat bez omezení a cenzury.

- Rychlost a dostupnost – nemusíte se spoléhat na servery třetí strany.

Model lze spustit buď na vlastním PC, což vyžaduje výkonný hardware, nebo v cloudu pomocí Google Colab. V tomto článku se zaměříme na druhou možnost.

Co je to VRAM a co znamenají parametry modelu?

VRAM (Video RAM) je speciální paměť grafické karty (GPU), která je nezbytná pro zpracování rozsáhlých jazykových modelů. Čím větší model, tím více VRAM potřebuje. Například:

- 1.5B parametrů – model s 1,5 miliardami parametrů, vhodný pro slabší GPU.

- 14B parametrů – model s 14 miliardami parametrů, vyžadující výkonnější GPU.

- 32B parametrů a více – modely s obrovskými požadavky na hardware, které jsou obtížně provozovatelné na běžném PC.

Číslo v názvu modelu (např. DeepSeek R1:14B) označuje počet parametrů modelu – čím vyšší číslo, tím složitější a výkonnější model.

Požadavky na hardware pro lokální běh

Pokud chcete DeepSeek R1 provozovat na vlastním počítači, budete potřebovat výkonné GPU. Níže je tabulka doporučeného hardwaru podle velikosti modelu:

| Velikost modelu | Doporučené GPU | Minimální VRAM |

|---|---|---|

| 1.5B | NVIDIA RTX 3060 | 12 GB |

| 7B | NVIDIA RTX 3090 / 4080 | 24 GB |

| 8B | NVIDIA RTX 4090 / A100 | 24 GB |

| 14B | NVIDIA RTX 4090 / A100 | 48 GB |

| 32B | NVIDIA A100 80GB | 80 GB |

| 70B | NVIDIA H100 | 80+ GB |

| 671B | NVIDIA H100 v8 (cluster) | více než 640 GB |

Pokud nemáte takto výkonné PC, můžete využít Google Colab, kde lze zdarma spustit modely do velikosti 32B.

Omezení v Google Colab

Google Colab nabízí bezplatné prostředí T4 s omezeným výkonem. Doporučené maximální velikosti modelů:

- 8B – odpověď za ~30 sekund, ale horší čeština

- 14B – odpověď za ~50 sekund, slabší čeština

- 32B – odpověď za 4+ minuty, nedoporučeno

Menší modely mají horší znalost češtiny a mohou dělat gramatické chyby nebo míchat slova ze slovenštiny a polštiny.

Politická cenzura

DeepSeek R1 obsahuje určitá omezení a odmítá odpovídat na politicky citlivá témata, např. protesty na náměstí Nebeského klidu. Lokální provoz umožňuje tyto restrikce obejít.

Jak spustit DeepSeek R1 v Google Colab

Nyní se podíváme, jak jednoduše rozběhnout model v Google Colab.

1. Přihlášení do Google Colab

Přejděte na Google Colab a přihlaste se.

2. Otevření notebooku

Otevřete tento notebook:

🔗 Open-WebUI-Colab

3. Připojení k prostředí GPU (T4)

Klikněte na „Běh“ > „Změnit typ běhového prostředí“ a nastavte „Hardware accelerator“ na GPU T4. Poté vpravo nahoře klikněte na „Připojit T4“.

4. Spuštění jednotlivých kroků

Notebook obsahuje několik buněk kódu. Postupně je spusťte kliknutím na tlačítko ▶️ u každé z nich. Při prvním spuštění první buňky se zobrazí upozornění, že sešit nepochází od Google – potvrďte, že ho chcete spustit. Níže je popis jednotlivých kroků:

- Instalace Ollama:

!curl -fsSL https://ollama.com/install.sh | shStáhne a nainstaluje Ollama, potřebný nástroj pro běh modelů. - Instalace závislostí:

!sudo apt-get update !sudo apt-get install -y python3.11 python3.11-venv python3.11-devAktualizuje balíčky a instaluje Python 3.11 a jeho vývojové nástroje. - Vytvoření virtuálního prostředí a instalace Open WebUI:

!python3.11 -m venv venv !source venv/bin/activate !venv/bin/python -m pip install --upgrade pip !venv/bin/pip install open-webuiNastaví oddělené virtuální prostředí a nainstaluje Open WebUI. - Vytvoření a spuštění skriptu pro servery:

with open('start_servers.py', 'w') as f: f.write(''' import subprocess import threading import os import time def start_ollama(): subprocess.run(['ollama', 'serve'], stdout=subprocess.DEVNULL, stderr=subprocess.DEVNULL) def start_open_webui(): subprocess.run(['venv/bin/open-webui', 'serve', '--port', '8081'], stdout=subprocess.DEVNULL, stderr=subprocess.DEVNULL) threading.Thread(target=start_ollama).start() time.sleep(5) threading.Thread(target=start_open_webui).start() ''')Tento skript spustí Ollama a Open WebUI souběžně. - Spuštění skriptu a vytvoření tunelu:

!venv/bin/python start_servers.py & sleep 20; echo | ssh -o StrictHostKeyChecking=no -p 443 -R0:localhost:8081 qr@a.pinggy.ioSpustí servery a zpřístupní je přes tunelovací službu.

Po dokončení těchto kroků bude Open WebUI dostupné přes vygenerovaný odkaz, který vypadá podobně jako tento: https://rnefe-34-16-253-130.a.free.pinggy.link.

Při kliknutí na odkaz se objeví hláška:

Caution: Make sure you trust this website before entering

This website is served through pinggy.io

Website IP: 34.16.253.130

Enter this website only if you trust whoever sent the link to you. Be careful about disclosing personal or financial information like passwords, phone numbers, or credit cards.Tady je potřeba kliknout na Enter Site.

5. Registrace do Open WebUI

Po otevření odkazu na Open WebUI se zobrazí úvodní obrazovka. Klikněte na Get started, čímž zahájíte proces registrace.

- Vytvoření účtu – Zadejte svoje přihlašovací jméno, e-mail a nastavte si bezpečné heslo. Na e-mail nechodí žádné potvrzení.

- Přihlášení – Po kliknutí na Vytvořit admin účet, budete automaticky přihlášení do Open WebUI

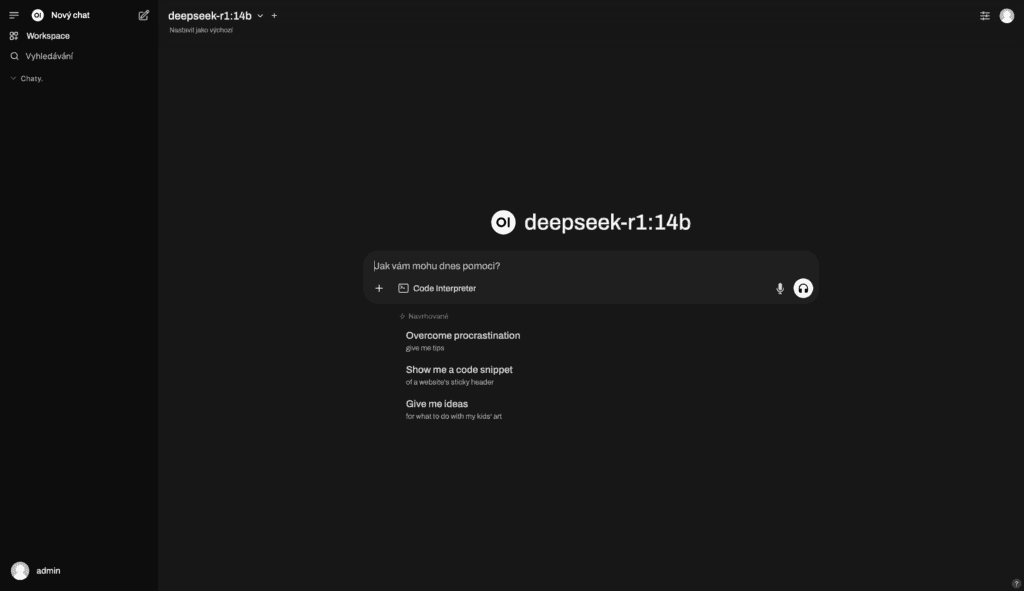

Po úspěšném přihlášení můžete začít používat WebUI.

6. Stažení modelu DeepSeek R1

Chcete-li stáhnout model deepseek R1, postupujte následovně:

- Vpravo nahoře klikněte na ikonu uživatele.

- Klikněte na „Adminis panel“.

- Vlevo nahoře klikněte na „Nastavení“.

- V levém svislém menu vyberte „Připojení“.

- U „Manage Ollama API Connections“ klikněte vpravo na šipečku znázorňující stahování (po najetí na tuto ikonu se zobrazí text „Spravovat“).

- Do políčka pod textem „Stáhněte model z Ollama.com“ napište model, který chcete stáhnout, například:

deepseek-r1:14bdeepseek-r1:32bdeepseek-r1:8b

- Klikněte vpravo vedle políčka na ikonu stahování.

- Po dokončení stahování můžete kliknout na „Nový chat“ a začít chatovat.

Závěr

Lokální provoz jazykových modelů přináší větší soukromí, kontrolu a nezávislost. Google Colab nabízí zdarma možnost spustit model DeepSeek R1 až do velikosti 32B, což je skvělá varianta pro ty, kteří nemají výkonné PC. Tento návod vám ukázal, jak model snadno spustit a využít jeho možnosti.

Komentáře